- Registriert

- 23 Jun 2020

- Beiträge

- 342

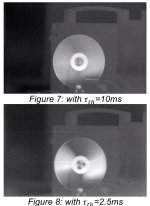

Hallo Carpenter.Zur Beurteilung würde aber eine Angabe von der Gesamt-Latenz (k.A. in welchen Einheiten) reichen. Ähnlich anderer Werte (NETD) die ja auch Dinge zusammen fassen.

Die ganze Diskussion erinnert mich an das Interview mit Christ Balke auf Youtube wo er sagt wir Jäger haben es ja in der Hand das Wild nicht auszurotten wenn wir z.B. nur ein Stück aus der Rotte erlegen und nicht dann noch 1-2 der flüchtigen Sauen beschießen. Da bekommt das Thema mit dem Flüchtigen beschießen eine neue Dimension.

Naja, das Problem mit dem NETD, das uns von Gehäuseherstellern angeboten wird, ist vergleichbar mit der Aussage:

“Hallo Chef, ich habe 1 Liter Regenwasser gesammelt.”

Schön, aber in welcher Zeit?

Wie stark hat es geregnet?

Wie oft hat es geregnet und wie oft musste gesammelt werden?

Wie groß war das Sammelgefäß?

Diese Informationen werden uns von den Gehäuseherstellern anscheinend mit gutem Grund vorenthalten.

Ohne diese Informationen kann man nicht beurteilen, ob jemand ein guter Regensammler ist oder nicht.

Aber wenn man weiß, dass 1 Liter Regenwasser bei leichtem Regen in 12 Stunden gesammelt wurde, und jede Stunde der Inhalt eines Schnapsglases gesammelt wurde, und alle 2 Stunden es 10 Minuten geregnet hat, kann man sehr wohl einschätzen, ob der Regensammler ein guter Mitarbeiter ist oder nicht.

Ohne diese Informationen bezahle ich womöglich einen Mitarbeiter umsonst.

Deshalb ist die von den Gehäuseherstellern genannte Zahl eine Zahl ohne Wert.

Reiner Marketinggag.

Ein Datenblatt des Sensors würde aber diese Miesere leicht ändern.

LG.WAKAN